Explainable AI: Khi máy không chỉ thông minh mà còn có thể giải thích được

Danh sách một số Data Insight của Fanpage

- Group Hiệp Hội Sales B2B Toàn Quốc : https://app.thealita.com/526217061602069

- Fanpage The Home Depot: https://app.thealita.com/106485550030

- Profile Cầu Thủ Tuyển Việt Nam Trần Đình Trọng: https://app.thealita.com/100004925382072

Trong kỷ nguyên số hóa bùng nổ như hiện nay, trí tuệ nhân tạo (AI) đã và đang trở thành một động lực mạnh mẽ định hình lại mọi mặt của đời sống, từ cách chúng ta giao tiếp, làm việc cho đến cách các doanh nghiệp vận hành. AI không chỉ thông minh trong việc xử lý lượng lớn dữ liệu, phát hiện ra các quy luật phức tạp và đưa ra dự đoán chính xác, mà giờ đây, với sự phát triển của Explainable AI, máy móc còn có thể giải thích được lý do đằng sau các quyết định và khuyến nghị của mình. Đây không chỉ là một bước tiến về mặt kỹ thuật mà còn là một cuộc cách mạng trong việc xây dựng niềm tin và sự minh bạch giữa con người và công nghệ.

Sự trỗi dậy của Trí tuệ nhân tạo và “Hộp đen” thách thức

AI đã chứng minh khả năng vượt trội trong việc giải quyết nhiều bài toán mà trước đây được coi là bất khả thi hoặc đòi hỏi sự can thiệp đáng kể của con người. Từ hệ thống gợi ý sản phẩm trên các nền tảng thương mại điện tử, công cụ dịch thuật tức thời, cho đến các hệ thống chẩn đoán y tế và xe tự hành, AI đang dần thay đổi cách chúng ta tương tác với thế giới. Đặc biệt, sự phát triển của học sâu (deep learning) và mạng nơ-ron nhân tạo đã mở ra kỷ nguyên của các mô hình AI có khả năng học hỏi từ dữ liệu khổng lồ, đạt được độ chính xác phi thường trong nhiều lĩnh vực. Tuy nhiên, đi kèm với sức mạnh vượt trội này là một thách thức lớn: tính “hộp đen” của nhiều hệ thống AI tiên tiến.

AI thay đổi thế giới nhưng ẩn chứa rủi ro

Trong các lĩnh vực nhạy cảm như y tế, tài chính hay luật pháp, việc chấp nhận một quyết định do AI đưa ra mà không hiểu rõ cơ sở của nó là một rủi ro đáng kể. Ví dụ, một hệ thống AI có thể dự đoán chính xác khả năng mắc bệnh của một bệnh nhân, nhưng nếu không thể giải thích tại sao lại đưa ra kết luận đó, bác sĩ sẽ khó lòng tin tưởng hoàn toàn để đưa ra phác đồ điều trị. Tương tự, trong ngành tài chính, việc một mô hình AI từ chối đơn xin vay vốn mà không có lời giải thích cụ thể có thể dẫn đến sự thiếu minh bạch và thậm chí là phân biệt đối xử. Sự phức tạp ngày càng tăng của các mô hình AI, đặc biệt là các mạng nơ-ron sâu với hàng tỷ tham số, khiến việc truy vết và hiểu được logic bên trong trở nên vô cùng khó khăn.

Vì sao “hộp đen” AI gây lo ngại?

Thiếu minh bạch là một vấn đề trung tâm. Khi một hệ thống AI hoạt động như một “hộp đen”, rất khó để xác định liệu nó có đang hoạt động một cách công bằng, không thiên vị hay không. Sự thiên vị trong dữ liệu huấn luyện có thể dẫn đến các quyết định phân biệt đối xử, ví dụ như từ chối cho vay đối với một nhóm dân số nhất định. Khả năng gỡ lỗi và cải thiện mô hình cũng bị ảnh hưởng nghiêm trọng. Nếu không biết tại sao mô hình đưa ra một quyết định sai, việc sửa lỗi trở nên mò mẫm và kém hiệu quả. Hơn nữa, với các quy định ngày càng chặt chẽ về quyền riêng tư dữ liệu và trách nhiệm giải trình của AI (như GDPR của Châu Âu hay Đạo luật AI sắp tới), yêu cầu về khả năng giải thích của các hệ thống AI trở nên cấp thiết hơn bao giờ hết, không chỉ vì lý do kỹ thuật mà còn vì lý do đạo đức và pháp lý.

Explainable AI là gì và tại sao lại cần thiết?

Explainable AI (XAI), hay Trí tuệ nhân tạo có thể giải thích được, chính là lời giải cho bài toán “hộp đen” nêu trên. XAI không chỉ tập trung vào việc tạo ra các mô hình AI có hiệu suất cao, mà còn chú trọng vào việc phát triển các phương pháp và kỹ thuật giúp con người hiểu rõ hơn về cách các mô hình này hoạt động, tại sao chúng lại đưa ra những quyết định cụ thể, và những yếu tố nào đã ảnh hưởng đến kết quả đó. Nói cách khác, XAI giúp mở “hộp đen” AI, biến những quyết định bí ẩn trở nên minh bạch và dễ hiểu hơn đối với người dùng cuối, các nhà phát triển và các cơ quan quản lý.

Định nghĩa cốt lõi của Explainable AI

Explainable AI là một tập hợp các phương pháp và kỹ thuật giúp con người hiểu được đầu ra của các hệ thống AI. Mục tiêu của XAI là tạo ra các hệ thống AI mà con người có thể hiểu, tin tưởng và quản lý một cách hiệu quả. Điều này bao gồm khả năng trả lời các câu hỏi như: “Tại sao mô hình lại đưa ra quyết định này?”, “Những yếu tố nào là quan trọng nhất đối với quyết định đó?”, “Khi nào mô hình có thể mắc lỗi?”, và “Làm thế nào để cải thiện mô hình?”. XAI không nhất thiết đòi hỏi phải có một mô hình AI hoàn toàn trong suốt, mà tập trung vào việc cung cấp các lời giải thích đủ rõ ràng và phù hợp với ngữ cảnh cho người dùng.

Lợi ích vượt trội mà Explainable AI mang lại

Việc tích hợp XAI mang lại nhiều lợi ích quan trọng. Đầu tiên và quan trọng nhất là tăng cường sự tin cậy và minh bạch. Khi người dùng hiểu được logic đằng sau các quyết định của AI, họ sẽ có xu hướng tin tưởng và chấp nhận công nghệ này nhiều hơn, đặc biệt trong các ứng dụng quan trọng. Thứ hai, XAI giúp phát hiện và giảm thiểu sai lệch (bias) trong mô hình. Bằng cách phân tích các yếu tố ảnh hưởng đến quyết định, chúng ta có thể nhận diện và khắc phục những thiên vị tiềm ẩn trong dữ liệu hoặc trong chính thuật toán, đảm bảo tính công bằng. Thứ ba, khả năng giải thích giúp các nhà phát triển cải thiện hiệu suất và độ chính xác của mô hình. Khi biết được điểm mạnh, điểm yếu của AI, họ có thể tinh chỉnh thuật toán hoặc thu thập dữ liệu tốt hơn. Thứ tư, XAI đóng vai trò then chốt trong việc tuân thủ các quy định pháp luật. Nhiều luật lệ mới yêu cầu các hệ thống tự động phải có khả năng giải thích để đảm bảo quyền của công dân. Cuối cùng, XAI hỗ trợ ra quyết định của con người, biến AI từ một công cụ tự động hóa thành một người cộng sự thông minh, cung cấp cái nhìn sâu sắc và nâng cao năng lực cho con người.

Các phương pháp và kỹ thuật phổ biến trong Explainable AI

Lĩnh vực Explainable AI đang phát triển nhanh chóng, với nhiều phương pháp và kỹ thuật đa dạng được phát triển để giải quyết các khía cạnh khác nhau của bài toán giải thích. Các phương pháp này thường được phân loại dựa trên việc chúng có phụ thuộc vào cấu trúc của mô hình AI hay không, và mức độ chi tiết của lời giải thích mà chúng cung cấp.

Các phương pháp giải thích dựa trên mô hình (Model-specific explanations)

Một số mô hình AI vốn dĩ đã có tính giải thích tốt. Ví dụ, các mô hình cây quyết định (decision trees) và rừng ngẫu nhiên (random forests) có thể dễ dàng được trực quan hóa, cho phép chúng ta theo dõi từng nhánh quyết định để hiểu tại sao một dự đoán cụ thể được đưa ra. Các mô hình tuyến tính như hồi quy logistic cũng thuộc nhóm này, nơi tầm quan trọng của mỗi đặc trưng được thể hiện rõ ràng qua các hệ số trọng số. Tuy nhiên, các mô hình này thường có giới hạn về độ phức tạp và hiệu suất so với các mạng nơ-ron sâu.

Các phương pháp giải thích độc lập với mô hình (Model-agnostic explanations)

Phần lớn các nghiên cứu về XAI tập trung vào các phương pháp độc lập với mô hình, nghĩa là chúng có thể được áp dụng cho bất kỳ mô hình AI nào mà không cần biết cấu trúc bên trong của mô hình đó. Điều này đặc biệt hữu ích cho các mô hình “hộp đen” phức tạp.

LIME (Local Interpretable Model-agnostic Explanations) là một trong những kỹ thuật nổi bật. LIME hoạt động bằng cách tạo ra các điểm dữ liệu nhiễu xung quanh một dự đoán cụ thể của mô hình, sau đó huấn luyện một mô hình tuyến tính đơn giản (và do đó dễ giải thích) trên các điểm dữ liệu nhiễu này để giải thích dự đoán cục bộ. Nói cách khác, LIME giải thích tại sao một mô hình phức tạp lại đưa ra một quyết định cụ thể cho một trường hợp cụ thể, bằng cách xấp xỉ hành vi của nó bằng một mô hình đơn giản tại khu vực lân cận của trường hợp đó.

SHAP (SHapley Additive exPlanations) là một kỹ thuật khác được phát triển dựa trên lý thuyết trò chơi. SHAP gán một giá trị Shapley cho mỗi đặc trưng, biểu thị mức độ đóng góp của đặc trưng đó vào dự đoán của mô hình, so với giá trị cơ sở trung bình. Giá trị Shapley có tính nhất quán và công bằng, cho phép chúng ta hiểu được vai trò của từng yếu tố trong việc dẫn đến kết quả cuối cùng của AI, cả ở cấp độ từng dự đoán cá nhân và cấp độ toàn cục của mô hình.

Ngoài ra, các kỹ thuật như Partial Dependence Plots (PDP) và Individual Conditional Expectation (ICE) plots cũng được sử dụng để trực quan hóa mối quan hệ giữa các đặc trưng đầu vào và đầu ra của mô hình, giúp khám phá các tương tác phức tạp và hiểu được tác động tổng thể của các đặc trưng lên dự đoán.

Ứng dụng thực tiễn của Explainable AI trong các ngành nghề

Khả năng giải thích của AI không chỉ là một khái niệm học thuật mà đang dần được áp dụng vào thực tế, mang lại giá trị to lớn trong nhiều ngành công nghiệp. Từ việc cải thiện quy trình ra quyết định cho đến tăng cường niềm tin của người dùng, XAI đang mở ra những cánh cửa mới cho việc triển khai AI một cách có trách nhiệm và hiệu quả hơn.

Y tế: Chẩn đoán đáng tin cậy và cá nhân hóa điều trị

Trong lĩnh vực y tế, XAI có tiềm năng cách mạng hóa cách bác sĩ và bệnh nhân tương tác với công nghệ. Một hệ thống AI có thể phát hiện bệnh ung thư từ hình ảnh y tế với độ chính xác cao, nhưng nếu nó có thể chỉ ra chính xác những vùng nào trên ảnh đã dẫn đến kết luận đó, hoặc giải thích những yếu tố nào trong bệnh án của bệnh nhân đã góp phần vào dự đoán, thì niềm tin của bác sĩ sẽ tăng lên đáng kể. Điều này không chỉ giúp bác sĩ đưa ra quyết định điều trị tốt hơn mà còn giúp bệnh nhân hiểu rõ hơn về tình trạng sức khỏe của mình, từ đó chấp nhận phác đồ điều trị một cách tự nguyện và có ý thức hơn. XAI cũng giúp cá nhân hóa điều trị, bằng cách giải thích tại sao một loại thuốc hoặc liệu pháp cụ thể lại phù hợp với một bệnh nhân dựa trên đặc điểm di truyền hoặc hồ sơ y tế của họ.

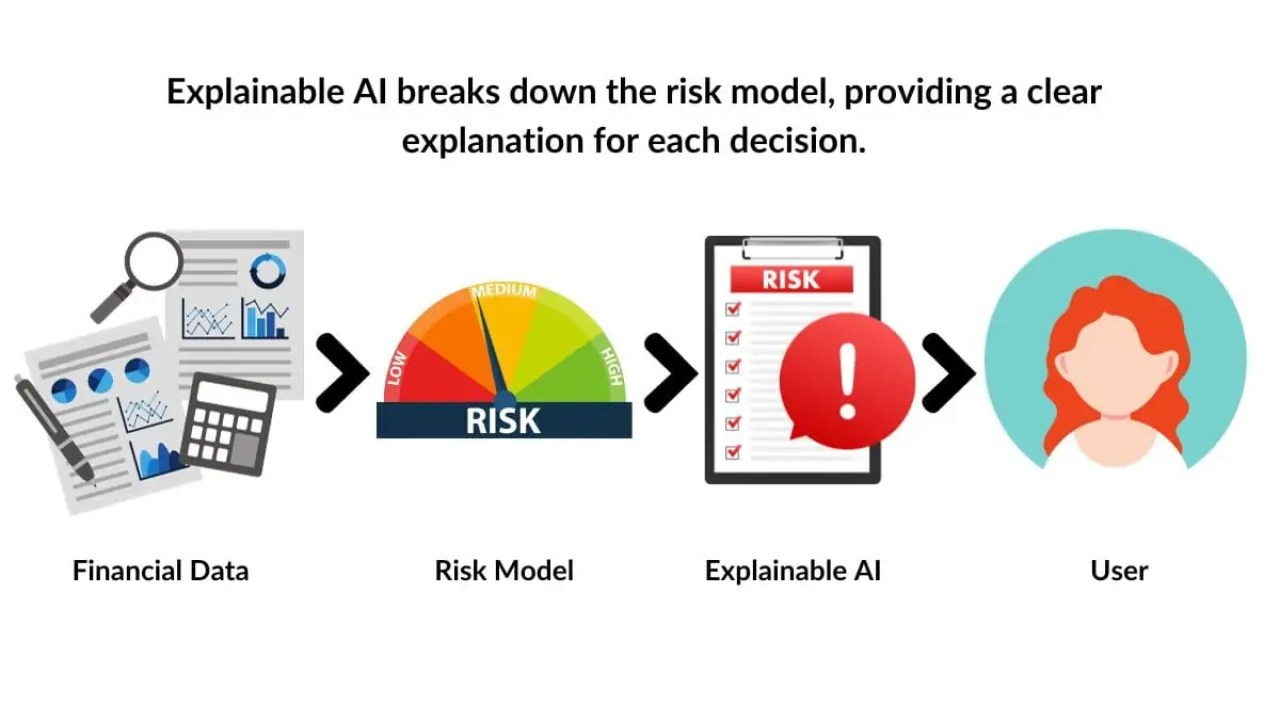

Tài chính: Quyết định cho vay và phát hiện gian lận minh bạch

Ngành tài chính là một trong những lĩnh vực đầu tiên nhận thấy tầm quan trọng của XAI. Trong quy trình xét duyệt khoản vay, các mô hình AI thường được sử dụng để đánh giá rủi ro tín dụng. Với XAI, khi một đơn xin vay bị từ chối, mô hình có thể giải thích cụ thể rằng nguyên nhân là do “điểm tín dụng thấp” hoặc “quá nhiều khoản nợ hiện tại so với thu nhập”, thay vì chỉ đưa ra một kết luận không rõ ràng. Điều này giúp người nộp đơn hiểu được lý do, cải thiện tình hình tài chính của mình và có cơ hội được chấp thuận trong tương lai. Tương tự, trong việc phát hiện gian lận, XAI có thể chỉ ra những giao dịch bất thường nào, ở đâu, và tại sao chúng bị coi là dấu hiệu của gian lận, giúp các chuyên gia an ninh tài chính phản ứng nhanh chóng và hiệu quả hơn.

Xe tự hành và An ninh quốc phòng: Đảm bảo an toàn và trách nhiệm giải trình

Trong các hệ thống quan trọng về an toàn như xe tự hành, khả năng giải thích là cực kỳ cần thiết. Nếu xảy ra một tai nạn, việc hiểu được tại sao chiếc xe lại đưa ra một quyết định cụ thể (ví dụ: phanh gấp, chuyển làn) dựa trên dữ liệu từ cảm biến và môi trường xung quanh là vô cùng quan trọng cho việc điều tra, cải thiện hệ thống và xác định trách nhiệm pháp lý. Tương tự, trong an ninh quốc phòng, các hệ thống AI được sử dụng để phân tích dữ liệu tình báo hoặc ra quyết định trong các tình huống nhạy cảm. XAI giúp đảm bảo rằng các quyết định này được đưa ra dựa trên logic rõ ràng, tránh các sai sót tiềm ẩn và tăng cường trách nhiệm giải trình.

Tương lai của Explainable AI: Từ lý thuyết đến hiện thực hóa tiềm năng

Mặc dù đã có những bước tiến đáng kể, Explainable AI vẫn là một lĩnh vực nghiên cứu và phát triển sôi động. Tương lai của XAI hứa hẹn sẽ mang lại nhiều đột phá, biến các mô hình AI không chỉ thông minh mà còn trở thành những đối tác đáng tin cậy của con người. Để hiện thực hóa tiềm năng này, chúng ta cần vượt qua một số thách thức và nắm bắt các cơ hội mới.

Thách thức và cơ hội phía trước

Một trong những thách thức lớn nhất là mở rộng quy mô các phương pháp XAI cho các mô hình AI cực kỳ lớn và phức tạp. Việc tạo ra lời giải thích cho một mạng nơ-ron với hàng tỷ tham số vẫn còn là một nhiệm vụ khó khăn. Ngoài ra, việc tiêu chuẩn hóa các số liệu để đánh giá chất lượng của các lời giải thích là một lĩnh vực đang được nghiên cứu. Làm thế nào để chúng ta biết liệu một lời giải thích có thực sự hữu ích, chính xác và dễ hiểu đối với người dùng cuối hay không? Giao diện người dùng để trình bày các lời giải thích một cách hiệu quả cho các đối tượng khác nhau (ví dụ: nhà khoa học dữ liệu, quản lý, khách hàng) cũng là một yếu tố quan trọng. Cơ hội nằm ở việc phát triển các thuật toán XAI hiệu quả hơn, các công cụ trực quan hóa mạnh mẽ và các quy trình tích hợp XAI vào vòng đời phát triển AI từ sớm.

Hướng tới một hệ sinh thái AI có trách nhiệm

Tương lai của Explainable AI không chỉ dừng lại ở việc phát triển các thuật toán mới. Nó còn liên quan đến việc xây dựng một hệ sinh thái AI có trách nhiệm, nơi tính minh bạch và đạo đức được đặt lên hàng đầu. Điều này đòi hỏi sự hợp tác giữa các nhà nghiên cứu, nhà phát triển, nhà quản lý và người dùng cuối. Việc tích hợp XAI vào giai đoạn đầu của quá trình phát triển AI, thay vì coi nó như một phần bổ sung sau này, sẽ giúp xây dựng các hệ thống AI đáng tin cậy ngay từ đầu. Các quy định và hướng dẫn đạo đức đóng vai trò quan trọng trong việc thúc đẩy việc áp dụng XAI rộng rãi hơn. Mục tiêu cuối cùng là tạo ra một thế giới nơi AI không chỉ là một công cụ tự động hóa các tác vụ mà còn là một đối tác thông minh, có thể nâng cao năng lực con người, cung cấp cái nhìn sâu sắc và đưa ra các quyết định một cách minh bạch và có trách nhiệm.

Explainable AI không chỉ là một thuật ngữ công nghệ mới mẻ mà là một cột mốc quan trọng trong sự phát triển của trí tuệ nhân tạo, đánh dấu sự chuyển mình từ những “hộp đen” bí ẩn sang những cỗ máy thông minh có khả năng đối thoại, giải thích và xây dựng niềm tin với con người. Khả năng này không chỉ mở ra cánh cửa cho việc ứng dụng AI sâu rộng hơn trong các lĩnh vực nhạy cảm mà còn là nền tảng vững chắc để xây dựng một tương lai nơi công nghệ phục vụ con người một cách minh bạch, công bằng và có đạo đức.